In der heutigen Informationsgesellschaft erreichen uns Nachrichten aus allen Richtungen - soziale Medienplattformen wie Instagram, Facebook und LinkedIn, Suchmaschinen wie Google, traditionelle Nachrichtenwebsites, E-Mails, private Nachrichten und allgegenwärtige Werbeanzeigen. Dies spiegelt die Realität in unseres gegenwärtigen Informationszeitalter wider.

Doch wie können wir inmitten dieses Informationsüberflusses das Vertrauen bewahren?

![The Era of Automated Fake Information | Fake News 3.0]()

Was versteht man unter Fake News 3.0?

Der Begriff "Fake News" ist uns allen geläufig und bezieht sich auf bewusst verbreitete, falsche Informationen, die mit der Absicht der Irreführung publiziert werden. Danach erschien "Fake News 2.0", angetrieben durch Fortschritte in der KI-Technologie. Diese Weiterentwicklung beinhaltet künstlich generierte Falschinformationen wie Deepfake-Videos, manipulierte Sprachaufnahmen und gefälschte Bilder.

Beispielsweise beinhalten diese Technologien Verfahren, die ähnlich wie bei Deepfakes arbeiten und den Eindruck erwecken können, als würde der frühere Präsident Trump behaupten, dass Einhörner existieren, oder als würde Präsident Putin sagen: "Die USA sind weitaus besser als Russland."

Dies war die Wirklichkeit unserer Zeit vor einigen Jahren.

Nun möchte ich Ihnen eine neue Realität präsentieren, ein neues Konzept: Fake News 3.0.

Dieser Begriff bezieht sich auf automatisierte, massenhaft generierte Fehlinformationen, eine Form der Täuschung, die noch gefährlicher ist als ihr Vorgänger. Stellen Sie sich eine Welt vor, in der selbst Informationen von den renommiertesten Quellen sorgfältig überprüft werden müssen. Nicht, weil diese Quellen absichtlich irreführen, sondern weil sie selbst Opfer automatisierter Fehlinformationen sein können. So können selbst E-Mails, die Sie lesen, Nachrichten, die Sie sehen, lesen und hören, falsch sein.

Aber wie genau funktioniert das? Und warum ist das wirklich so gefährlich?

Schauen wir uns einige Beispiele an.

Ein Experiment: Die Erstellung eines Fake News 3.0 Bots

Kürzlich habe ich einen Bot entwickelt, der in der Lage ist, gefälschte Nachrichten zu generieren, nicht aus böser Absicht, sondern um die Möglichkeiten der KI und Automatisierung in diesem Kontext zu erkunden. Inspiriert von der Frage: Was wäre, wenn?

Als Head of Digital bei Tecnovy ist mein Hauptziel die Optimierung unserer Online-Präsenz durch strategisches Backlinking und Suchmaschinenoptimierung (SEO). Gängige Tools für dieses Vorhaben umfassen Plattformen wie HARO (Help a Reporter Out) und Terkel, die Journalisten mit Expertenquellen verbinden.

Inmitten einer Flut von HARO-Anfragen sah ich mich mit Engpässen konfrontiert. Da kam mir der Gedanke: Könnte Automatisierung die Lösung sein? Könnte ich GPT nutzen, um auf diese Anfragen so zu antworten, dass sie nicht offensichtlich maschinell generiert erscheinen?

Um diese Idee zu überprüfen, habe ich Zapier zur Automatisierung verwendet. Manche mögen meinen, dass eine von GPT generierte Antwort leicht zu erkennen wäre, aber der Trick besteht darin, die Ausgabe so zu verfeinern, dass sie von einer von Menschen erstellten E-Mail nicht zu unterscheiden ist.

Probieren wir das einfach mal.

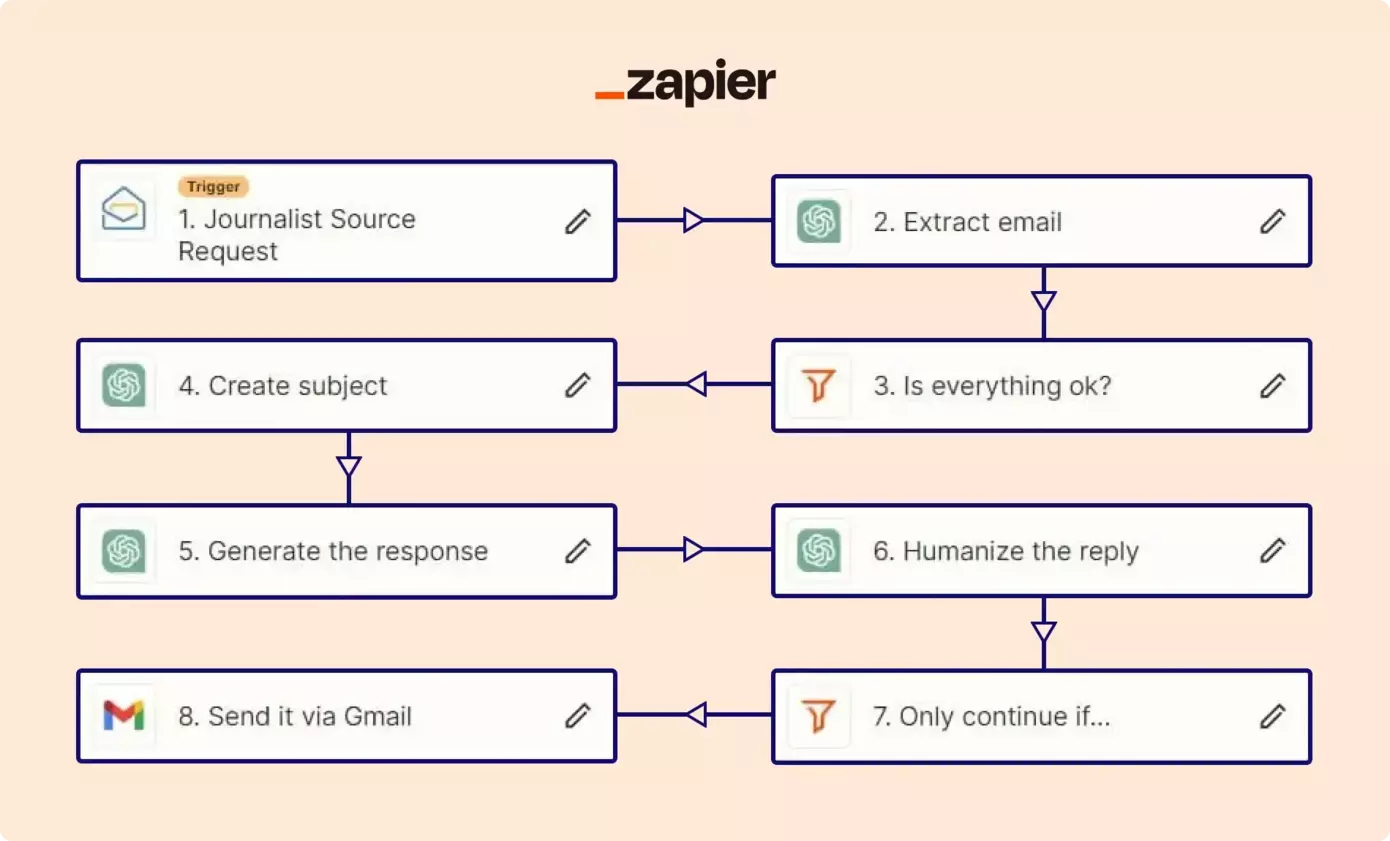

Menschenähnliche Fake-Mails auf Autopilot in nur 8 Schritten

Ich habe diesen Bot in 8 Schritten erstellt. Die Prompts hätten verbessert werden können, aber für den Zeitaufwand funktioniert es immer noch ganz gut. Im Folgenden möchte ich die einzelnen Schritte erläutern und die Ergebnisse überprüfen.

-

Journalistische Quellenanfrage (siehe Screenshot.)

> Die Arbeitsfolge des Bots wird ausgelöst, sobald ich eine neue E-Mail von HARO erhalte. -

E-Mail extrahieren (siehe Screenshot.)

> In diesem Schritt wird die E-Mail des Journalisten aus den Rohdaten extrahiert. -

Ist alles in Ordnung? (siehe Screenshot.)

> Hier wird geprüft, ob die extrahierte E-Mail des Journalisten korrekt ist. Wenn nicht, wird die Sequenz abgebrochen. -

Betreff erstellen (siehe Screenshot.)

> Wir brauchen eine E-Mail-Überschrift, richtig? Wir erstellen sie in diesem Schritt und werden sie später verwenden. -

Generierung der Antwort (siehe Screenshot.)

> Jetzt erstellen wir den E-Mail-Text. Er enthält eine einfache Aufforderung. Die Vermenschlichung kommt danach. -

Vermenschlichung der Antwort (siehe Screenshot.)

> Der Empfänger sollte nicht auf den ersten Blick erkennen können, dass meine E-Mail von einer KI geschrieben wurde. Um die Dinge natürlicher erscheinen zu lassen, vermenschlichen wir den Körper mit ein paar menschenähnlichen Mustern. Emotionen und häufige Grammatikfehler. -

Nur fortfahren, wenn… (siehe Screenshot.)

> Bevor wir die E-Mail abschicken, müssen wir überprüfen, ob wir alles richtig gemacht haben. Wenn nicht, brechen Sie ab. -

Sendung der E-Mail über Gmail (siehe Screenshot.)

> Fügen Sie alle Daten an den richtigen Stellen ein, fügen Sie meine Unterschrift am Ende hinzu und senden Sie sie ab. So einfach ist das.

Der Bot hat mehr als 200 Mails verarbeitet. Wie sahen die Ergebnisse aus?

Ja, der Bot hat über 200 E-Mails analysiert. Und wissen Sie was? Die Ergebnisse waren äußerst aufschlussreich. Lassen Sie uns das in Relation setzen: Ich habe nur 3 Stunden gebraucht, um diesen Bot zu entwickeln. Stellen Sie sich einmal vor, welches Potenzial sich eröffnen würde, wenn ich 300 Stunden investiert hätte – oder wenn die Person hinter dem Bot weniger noble Absichten verfolgt hätte.

Beispielergebnis #1 (Hier klicken.)

Wir haben letztes Jahr keine KI-Chatbots eingeführt. Keine Verbesserungen bei den Zufriedenheitswerten oder der Reaktionszeit. Wir haben mit keinem Freelancer zusammengearbeitet, keine Zeit gespart, keinen Aufschwung gesehen.

Beispielergebnis #2 (Hier klicken.)

Wir bieten noch kein SaaS an und haben auch keine gestaffelte Preisstrategie. Auch bei unseren Kursanmeldungen konnten wir keinen sprunghaften Anstieg feststellen. Ich muss jedoch zugeben, dass Adobe und Salesforce gute Beispiele sind.

Beispielergebnis#3 (Hier klicken.)

Wir hatten nie einen E-Commerce-Kunden. Das Ende der Geschichte.

Beispielergebnis #4 (Hier klicken.)

Das könnte wahr sein! Wir haben begonnen, Social Proof zu nutzen, und das hat unsere Konversionsrate erhöht. Allerdings liegen uns hierzu keine Statistiken vor. Also... diese Information könnte tatsächlich fast wahr sein. :)

Beispielbild meiner Sent-Box (Hier klicken.)

Die E-Mail-Betreffzeilen sind einander zu ähnlich. Ich könnte es etwas mehr randomisieren, aber das war mir egal. Sie sollten auf jeden Fall einmal pro Person gesehen werden.

You were the victim, but a lucky one. (yet)

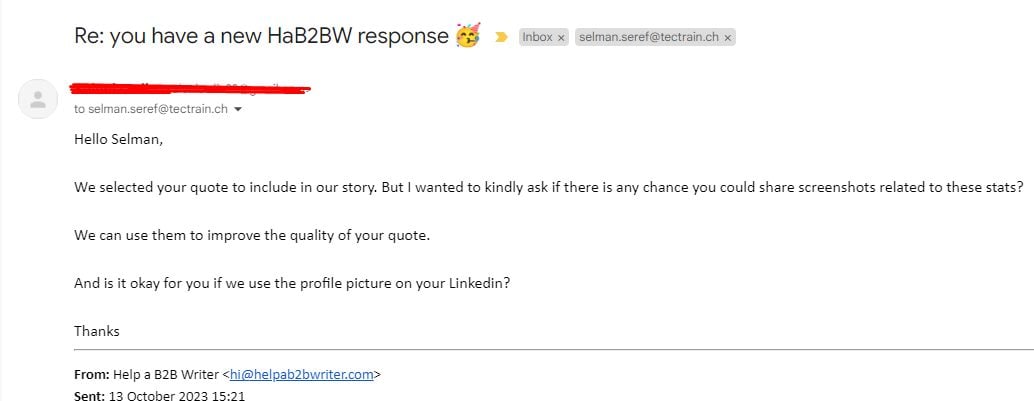

- Von den über 200 E-Mails, die ich verschickt habe, habe ich etwa 25 zurückbekommen (fast 10 %).

- Die Hälfte von ihnen wollte mehr Informationen wie Statistiken oder Bilder.

- Ein paar meinten, meine Antworten seien zu vage.

- Aber hören Sie sich das an: Etwa 10 waren einverstanden und wollten meine Kommentare in ihre Geschichten einbauen!

Selbstverständlich war es erforderlich, ihnen mitzuteilen, dass sie sich zurückhalten sollten, da dies alles im Rahmen einer wissenschaftlichen Untersuchung geschah. A few people laughed, a few people cried, most people were silent.

Antwortbeispiel #1

Antwortbeispiel #2

Antwortbeispiel #3

Antwortbeispiel #4

Ich habe nicht zugelassen, dass jemand das, was ich geschickt habe, veröffentlicht. Ich suche jeden Tag online, um zu sehen, ob mein Name in irgendwelchen Artikeln auftaucht. Wenn das der Fall ist, werde ich sie bitten, ihn zu löschen.

Auch die Namen der Journalisten und die Plattformen, auf denen sie schreiben, habe ich nicht preisgegeben. Ich möchte weder der Karriere noch dem Ruf von irgendjemandem schaden. Das war nur ein Experiment, nichts weiter. Aber das ist nun einmal meine Art. :)

Das war nur die Kostprobe. Was ist möglich?

Was Sie gerade gesehen haben, ist nur ein kleiner Eindruck; die vollen Möglichkeiten von Fake News 3.0 sind viel bedenklicher. Lassen Sie mich im Folgenden kurz ein paar Optionen nennen. ?

![Automated Fake Article Networks]()

1- Automatisierte Fake-Artikel-Netzwerke

Bevor ich dies erkläre, möchte ich betonen, dass ich diese Idee faszinierend finde. Möglicherweise werde ich sie sogar in Zukunft für ein passives Einkommen nutzen. ?

- Zuerst schaffen wir die Infrastruktur: 100 WordPress-Websites, jede mit ihrer eigenen einzigartigen Domain und Sprache. Ich werde sogar abgelaufene Domains für sofortige SEO-Stärke verwenden.

- Als Nächstes erstelle ich ein automatisiertes System - einen "Strategie-Bot", der täglich Hunderte von komplexen Content-Strategien entwickeln kann und diese ordentlich in einer Datenbank speichert.

- Dann kommt der "Content Writer Bot", der darauf ausgelegt ist, auf die Strategiedatenbank zuzugreifen und sie zu nutzen. Keine zufällige Generierung mehr; alles folgt einem Plan, um Überlappungen von Schlüsselwörtern zu vermeiden.

- Aber warten Sie, es gibt noch mehr! Hier ist der "Editor Bot", der relevante Bilder generiert, Artikel strukturiert und interne Verlinkungen wie ein Profi handhabt.

- Jetzt drücke ich auf die Veröffentlichungstaste. Nicht für einen Artikel. Nicht für eine Website. Sondern für 100 Artikel auf 100 Domains, im Autopilotmodus und bis zu 10.000 Artikel pro Tag!

- Als Sahnehäubchen aktiviere ich ein Übersetzungs-Plugin. Diese 10.000 Artikel sind nun in Dutzenden von Sprachen verfügbar.

Aber, worauf zielt das ab? Das ist der entscheidende Punkt. Stellen Sie sich vor, es handelt sich um eine Regierung oder ein großes Unternehmen. Skalieren Sie diese Zahlen hoch und sehen Sie, welch monumentalen Einfluss sie haben könnten.

2- Täuschende E-Mails mit persönlichen Daten

Datenschutz, DSGVO usw. sind uns bekannt, richtig? Doch das ist nicht immer so eindeutig. Als normaler Internetnutzer habe ich Zugang zu den privaten Daten von Millionen von Menschen. Schon mal vom Deepweb gehört?

Dort werden sie verkauft. Und hier sprechen wir von offizielle Regierungsdaten. Nicht nur die Daten, die Sie "implizit" zugegeben haben zu teilen. Vielmehr sprechen wir hier von Telefonnummern, Namen Ihrer Familienmitglieder, Adressen, Arbeitsplätzen, Schulen - alles. Keine Übertreibung. Trotz regulatorischer Bemühungen gibt es Datenlecks, und öffentliche Datenbanken sind nicht unbedingt Fort Knox.

Wer ist eher bereit, Spitzengehälter für Cybersicherheitstalente zu zahlen - ein Unternehmen oder eine Regierungsbehörde? (Das Unternehmen, siehe die Forschung.) Und wer kann mehr Geld verdienen: ein Cybersicherheitsspezialist, der Datenlecks verhindert, oder ein Hacker, der von ihnen profitiert?

Genug Kontroversen. Wir wissen, dass Datenlecks real sind, egal wie.

Stellen Sie sich nun Folgendes vor:

-

Ich erstelle einen E-Mail-Bot, der die persönlichen Daten nutzt, die ich gesammelt habe.

-

Ich programmiere diesen Bot so, dass er eine Geschichte basierend auf Ihren Lebensdetails entwirft.

-

Die resultierende Geschichte dient als Hintergrund für ein Betrugs- oder Erpressungsschema, das direkt in Ihr Postfach geschickt wird.

Nun gehen wir einen Schritt weiter.

![Fake News 3.0 Phone Scams]()

3- Telefonbetrug mit Stimmklonung

Wir haben über E-Mails gesprochen. Wie sieht es mit Telefonanrufen aus?

- Zunächst erwerbe ich eine Fülle von Daten, ähnlich der zuvor besprochenen Methode.

- Ich richte ein virtuelles Callcenter ein, das von KI betrieben wird und über eine Vielzahl virtueller Telefonnummern verfügt.

- Dieser Bot initiiert Anrufe bei Ihren Angehörigen und führt unscheinbare Gespräche oder Umfragen über deren Tag, Schule oder Arbeit.

- Der entscheidende Punkt ist jedoch, dass der Bot diese Gespräche aufzeichnet, aber das ist nur der Auftakt für den eigentlichen Betrug.

- Mit diesen aufgezeichneten Ausschnitten generiert der Bot Sprachprofile für Ihre Familienmitglieder, die in der Lage sind, ihre Sprechmuster innerhalb einer Minute oder weniger zu imitieren. Denken Sie daran, wir streben keine Studioqualität an; es handelt sich um einen Telefonanruf, und bescheidene Klangqualität würde genügen.

- Schnell vorwärts, Sie genießen an einem schönen Tag die Sonne, Ihr Telefon klingelt, Sie nehmen ab, und am anderen Ende ist Ihre verzweifelte Tochter, die behauptet, sie sei entführt worden und dringend auf Bitcoin für ihr Lösegeld angewiesen.

Erinnert das nicht an Szenen aus einem Thrillerfilm? Lassen Sie sich das noch einmal durch den Kopf gehen. Dies ist keine übertriebene Vorstellung; es ist so einfach und plausibel wie die Planung Ihres Abendessens. Das gegebene Beispiel mag grundlegend erscheinen, aber die Realität könnte weitaus komplexer und gefährlicher sein.

Vielleicht würden Sie sich vor diesem Betrug schützen können, aber sind Sie sich sicher, dass Ihre Angehörigen die gleiche Sicherheit haben würden?

Plot-Twist: Ich habe mir diese Methode nicht ausgedacht. Ich habe gerade den Prozess erklärt. Es ist bereits da draußen, schauen Sie sich das an.

![Manipulating Journalists | Fake News 3.0]()

4- Manipulation des Journalismus

Halten Sie sich fest, denn dies ist ein entscheidender Moment, um den Zustand des Journalismus und der digitalen Information heute zu verstehen. Wie Sie bereits wissen, habe ich durch Plattformen wie HARO und TERKEL gefälschte Zitate an Journalisten geliefert. Lassen Sie mich klarstellen - ich bin weder ein PR-Experte noch ein professioneller Journalist. Ich bin einfach eine Person, die von den Grenzen digitaler Möglichkeiten fasziniert ist.

Betrachten Sie diese beunruhigende Aussicht:

- In nur drei Tagen könnte ich eine umfassende Datenbank erstellen, die die E-Mail-Adressen Tausender Journalisten enthält.

- Ja, Sie haben richtig gehört. Diese E-Mail-Adressen sind bereits zum Kauf erhältlich, wenn man weiß, wo man suchen muss.

- Hier kommt der nuancierte Teil. Anstatt Einheitsangebote zu senden, würde ich diese Journalisten sorgfältig nach ihren Berichterstattungsbereichen kategorisieren.

- Indem ich ihre zuvor veröffentlichten Artikel untersuche und ihre Hauptinteressen erkenne, könnte ich äußerst personalisierte E-Mails erstellen.

- Diese Kommunikationen wären nicht nur zielgerichtet, sondern würden mit der einzigartigen Karriere und dem Fokus eines jeden Journalisten in Resonanz stehen.

- Ich kann Geschichten, Profile, Fallstudien, Statistiken, Quellen, Nachrichten erfinden... Fiktive Informationen im Autopilotmodus erstellen und die Erzählung in jede gewünschte Richtung lenken.

Aber wofür ist das gut?

Das Ziel wäre, die Erzählung subtil zu beeinflussen. Hierbei geht es nicht nur darum, mediale Aufmerksamkeit zu erlangen, sondern darum, die öffentliche Meinung aus dem Hintergrund zu formen.

Denken Sie daran! Der Punkt hierbei ist nicht, was ich mit solchen Fähigkeiten tun könnte; es dient vielmehr dazu zu verdeutlichen, was von Akteuren mit erheblichen Ressourcen und potenziell fragwürdigen Absichten in großem Maßstab umgesetzt werden könnte.

Technology is morally neutral until we apply it. It's up to us to decide how we use it.

William Gibson

![AI Controlled Social Media Accounts]()

5- KI-Gesteuerte autonome Social-Media-Bots

Stellen Sie sich ein Szenario vor, das den von mir bereits genannten Beispielen ähnelt.

- Stellen Sie sich eine Armee von KI-gesteuerten Bots auf Plattformen wie Twitter, Facebook, Instagram, LinkedIn und TikTok vor.

- Diese Bots twittern oder posten nicht einfach nur allgemeine Inhalte, sondern agieren und interagieren, als wären sie echte Menschen.

- Sie kommentieren aktuelle Themen, diskutieren über das Wetter, teilen Fotos (Bilderzeugung, z. B. DALLE, Midjourney) aus ihrem "Leben" und empfehlen sogar Bücher.

Aber jetzt kommt der verblüffende Teil. In dem Moment, in dem die Person, die hinter diesen Bots steht, entscheidet, dass es an der Zeit ist, die Erzählung zu ändern, treten die Bots in Aktion. Sie überschwemmen die sozialen Feeds mit strategisch ausgewählten Inhalten und verändern so die aktuellen Themen und sogar die übergreifende Berichterstattung.

Für den zufälligen Beobachter erscheinen diese Konten echt - mit einer langen Historie plausibler Beiträge und Bilder. Was bedeutet das nun im Großen und Ganzen? Wir sprechen hier nicht nur über Gruppendynamik, sondern über die Mechanismen der Manipulation des Massenglaubens.

A reliable way to make people believe in falsehoods is frequent repetition, because familiarity is not easily distinguished from truth.

Daniel Kahneman

Das Erschütternde daran ist nicht nur, dass Fake News 3.0 automatisiert sind, sondern auch, dass diese Maschinerie in einem fast unvorstellbaren Ausmaß skaliert werden kann. Die Grenzen zwischen Realität und Fälschung verschwimmen und drohen, nicht nur individuelle Meinungen, sondern auch die Grundlagen der gesellschaftlichen Wahrheit zu erschüttern.

Ist das zu Black-Mirror-artig?

Die oben genannten Szenarien waren nur die Beispiele, die mir beim Schreiben dieses Artikels eingefallen sind, wofür ich insgesamt einige Stunden gebraucht habe. Sie können wie ein Kapitel aus Black Mirror wirken, als ob sie unwahrscheinlich wären.

Aber es ist mehr als wahrscheinlich, dass sie gerade jetzt passieren. Ich kenne bereits Dutzende von Websites, die Artikel mit GPT auf Autopilot generieren, um Klicks, also Anzeigenklicks, zu erhalten und Geld zu verdienen. (Sie verdienen übrigens Geld, Tausende von Dollar pro Monat. Schauen Sie nach.)

Auch Sie können das tun. Und ich bin mir sicher, dass es jemand anderes mit mehr Ressourcen, Zeit und Engagement viel besser machen kann als die von mir genannten Beispiele.

Die fortschreitende Technologie hat uns neue Horizonte eröffnet, aber... Das erinnert mich an ein Zitat aus dem Buch "Sapiens":

...die landwirtschaftliche Revolution war eine Falle.

Yuval Noah Harari

Alte Gatekeeping-Algorithmen können neue KI-Bots nicht erkennen

Traditionelle Sicherheitsmechanismen wie E-Mail-Firewalls, Server-Firewalls und Spam-Detektoren wurden für eine andere Zeit entwickelt. Diese Systeme arbeiten auf der Grundlage bekannter Muster, um potenziell schädliche oder falsche Informationen zu erkennen.

Die generative KI hat jedoch eine neue Ebene der Komplexität eingeführt, da sie in der Lage ist, die Merkmale authentischer Nachrichten und Inhalte zu imitieren.

Mit anderen Worten: Die rasante Entwicklung der KI hat die Fähigkeiten vieler bestehender Schutzsysteme effektiv überholt. Wir können KI so programmieren, dass sie diese etablierten Muster umgeht und unsere E-Mails, Artikel und Social-Media-Beiträge praktisch nicht mehr von legitimen, von Menschen erstellten Inhalten zu unterscheiden sind.

Ja, es werden immer ausgefeiltere KI-gestützte Erkennungssysteme entwickelt, aber das ist ein ständiges Wettrüsten. In dem Maße, in dem die Erkennungsinstrumente fortschrittlicher werden, steigen auch die Möglichkeiten derjenigen, die versuchen, zu manipulieren oder zu täuschen.

Das bringt uns zum Kern des Problems: Technologie allein kann nicht der ultimative Schutz sein. Die wirksamste Verteidigungslinie in dieser sich ständig weiterentwickelnden Landschaft ist das menschliche Bewusstsein. Es müssen neue Formen der Medienkompetenz entstehen, die uns nicht nur lehren, wie wir Fakten von Fiktion unterscheiden können, sondern auch, wie wir uns in einer Welt zurechtfinden, in der die "Wahrheit" von einem Algorithmus generiert werden kann.

Vorsicht vor Fake News 3.0: Was sollen wir also tun?

Mit dem Aufkommen von Fake News 3.0 sind betrügerische Informationen nicht nur allgegenwärtig, sondern auch immer überzeugender. Sie sind gut gemacht, um echt zu erscheinen, und können die alten Sicherheitssysteme, auf die wir uns verlassen haben, leicht ausschalten.

Wie können Sie sich also schützen? Eine der wirksamsten Strategien ist die Rückbesinnung auf die altbewährten Grundprinzipien der Skepsis und des kritischen Denkens. Es ist heute wichtiger denn je, nicht automatisch alles zu glauben, was man liest oder hört, ganz gleich, wie authentisch es scheint. Nehmen Sie sich einen Moment Zeit, um die Informationen zu überprüfen, Quellen zu vergleichen und sogar die Glaubwürdigkeit dieser Quellen zu hinterfragen.

Eine Herausforderung dabei ist das Vorhandensein kognitiver Verzerrungen, die Ihr Urteilsvermögen beeinträchtigen können. So neigen wir beispielsweise dazu, Informationen zu glauben, die mit unseren bereits bestehenden Überzeugungen übereinstimmen. Wenn Sie sich einer bestimmten politischen Haltung verschrieben haben, sind Sie vielleicht eher bereit, Nachrichten zu glauben, die diese Haltung unterstützen, ohne ihre Authentizität in Frage zu stellen.

Ein weiteres Beispiel ist der "Heiligenschein-Effekt", bei dem wir eher bereit sind, Informationen zu glauben, die von einer Quelle stammen, die wir bewundern oder für glaubwürdig halten, selbst wenn diese Informationen falsch oder irreführend sind.

Wenn Sie sich solcher Vorurteile bewusst sind, können Sie objektiver mit Nachrichten und Informationen umgehen. Wirken Sie diesen Voreingenommenheiten aktiv entgegen, indem Sie Informationen aus verschiedenen Quellen suchen und offen für Standpunkte sind, die Ihre eigenen in Frage stellen.

Die beste Verteidigung gegen diese wachsende Bedrohung ist schließlich Medienkompetenz und -erziehung. Wenn Sie die Mechanismen der Medien verstehen, von der Entstehung bis zur Verbreitung von Nachrichten, haben Sie die Möglichkeit, Fakten von Fiktion zu unterscheiden.

In einer Welt, in der selbst etablierte Journalisten und angesehene Nachrichtensender raffinierten Fälschungen zum Opfer fallen, ist ein gründliches Verständnis der Medienprozesse unser zuverlässigster Schutz.

Medienkompetenz ist nicht mehr nur eine "Nice-to-have"-Fähigkeit, sondern wird zu einem wesentlichen Bestandteil eines informierten und verantwortungsbewussten Bürgers.

Der größte Feind des Wissens ist nicht Unwissenheit, sondern die Illusion, wissend zu sein.

Daniel J. Boorstin

Quellen und weiterführende Literatur

-

Hunt, E. (2016, December 17). What is fake news? how to spot it and what you can do to stop it. The Guardian. https://www.theguardian.com/media/2016/dec/18/what-is-fake-news-pizzagate

-

Kahneman, D. (2011). Illusions of Truth. In Thinking, fast and slow (p. 63). essay, Penguin books.

-

Knight, W. (2020, April 2). Fake news 2.0: Personalized, optimized, and even harder to stop. MIT Technology Review. https://www.technologyreview.com/2018/03/27/3116/fake-news-20-personalized-optimized-and-even-harder-to-stop/

-

Martinez-Conde, S. (2019, October 5). I heard it before, so it must be true. Scientific American Blog Network. https://blogs.scientificamerican.com/illusion-chasers/i-heard-it-before-so-it-must-be-true/

-

Kelly, H. (2023, October 16). How to avoid falling for misinformation, AI images on social media. The Washington Post. https://www.washingtonpost.com/technology/2023/05/22/misinformation-ai-twitter-facebook-guide/

-

Kohli, A. (2023, April 29). Ai voice cloning is on the rise. here’s what to know. Time. https://time.com/6275794/ai-voice-cloning-scams-music/

- Cybenko, A.K., & Cybenko, G.V. (2018). AI and Fake News. IEEE Intelligent Systems, 33, 1-5.